Divergencias modernas.

Hace unos día vimos cómo Johann Bernoulli demostró que las suma de los inversos de los números naturales era una suma infinita.(En lenguaje de hoy: que la serie armónica es divergente). Dijimos que la demostración hoy no se consideraría rigurosa por el tratamiento del infinito tan alegre que en ella se hace: se considera como un infinito actual, y se opera con él sin ningún respeto.

Hace unos día vimos cómo Johann Bernoulli demostró que las suma de los inversos de los números naturales era una suma infinita.(En lenguaje de hoy: que la serie armónica es divergente). Dijimos que la demostración hoy no se consideraría rigurosa por el tratamiento del infinito tan alegre que en ella se hace: se considera como un infinito actual, y se opera con él sin ningún respeto.Hoy vamos a ver, si les parece, cómo se evita este problema y cómo se convierte en rigurosa la demostración.

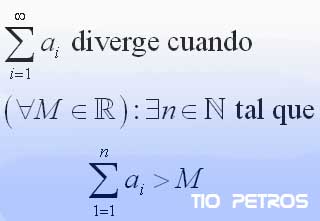

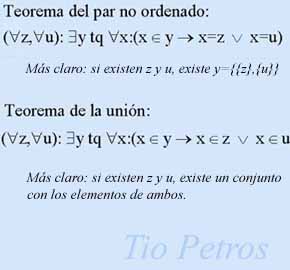

EL argumento finitista, tan al gusto de la matemática moderna, viene definido en la ilustración. Si uno no está acostumbrado, las frases en las que intervienen los símbolos de para todo , o existe un , son un poco liosas en apariencia, pero un pequeño esfuerzo será recompensado.

Escojamos un número M, tan grande como queramos. Si sucede que sumando elementos de la serie siempre conseguimos sobrepasarlo, entonces decimos que la serie diverge. n es la cantidad de elementos de la serie que hemos tenido que sumar para alcanzar el valor M. Si consigo demostrar que, sin importar el valor de M, siempre habrá un valor de n que cumpla este requisito, habré demostrado que la serie es divergente.

La lógica del razonamiento es aplastante, y así hemos evitado toda referencia al infinito.

En el caso de nuestra serie, la demostración sería así:

Si agrupamos los sumandos de la siguiente manera:

1+[1/2+...+1/10] + [1/11+1/12+...+1/100]+[1/101+...+1/1000]+...

El primer corchete tiene 9 elementos, el segundo 90, el tercero 900 y así sucesivamente.

Para cualquiera de dichos corchetes (por ejemplo el primero) podemos razonar así:

[1/11+1/12+...+1/100] > [1/100+1/100+...+1/100], ya que hemos sustituido todos los sumandos por el último, que es el menor. Y esta última suma vale 0,9 . De la misma forma, cualquier corchete vale 0,9 (90 veces 1/100, ó 900 veces 1/1000, ó 9000 veces 1/10000 da lo mismo, verdad?

Hemos demostrado que podemos agrupar los sumandos de la serie armónica en grupos que sumen más de una cantidad fijada y mayor que cero. Dado que disponemos de tantos grupos de estos como queramos, dado un número M, por grande que sea, nos bastará tomar un cierto números de corchetes de los anteriores para sobrepasar el valor de M.

Por lo tanto, LA SERIE ARMONICA DIVERGE .

Que es lo que queríamos demostrar.

_________________________________________________________________________________

Yo no sé qué les parecerá a ustedes esta demostración, pero aún recuerdo cuando se la expliqué a un buen amigo mío. Se llama Pedro. Le gustó tanto que me impresionó cómo a ciertas personas un buen razonamiento les puede hacer el efecto de una historia bien contada, de una película estupenda o de una música arrebatadora.

Y es que, con ciertas audiencias, da gusto. ;)

NOTA.- La definición "buena" de convergencia de una serie es un poquitín más complicada que la aquí explicada. Ello es debido a que, en la generalidad, una serie puede ser más perversa de lo que es la armónica que aquí nos ocupa. La simplificación ha sido realizada en aras de una mayopr claridad en la definición. En otro post hablaremos de ello.

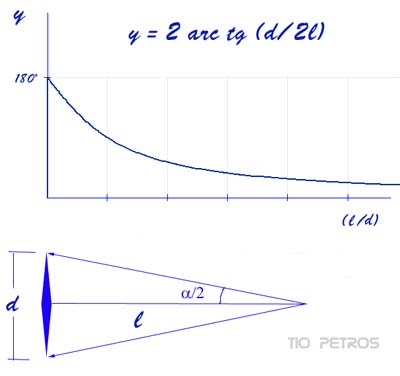

Todos sabemos que cuanto más lejos está un objeto, más pequeño lo vemos. Hablamos en todo caso de observación directa, sin instrumentos de aumento. Nos vendrá bien comprender el motivo y cuantificar un poco el asunto. En la figura aparece un objeto, como un rombo alargado, visto desde un punto a una distancia l, siendo d la diagonal mayor del rombo. Lo importante desde nuestro punto de observación es el ángulo alfa que ocupa el objeto. Cuando hablemos del tamaño aparente del rombo, nos referiremos a dicho ángulo. Con un poco de trigonometría, vemos que

Todos sabemos que cuanto más lejos está un objeto, más pequeño lo vemos. Hablamos en todo caso de observación directa, sin instrumentos de aumento. Nos vendrá bien comprender el motivo y cuantificar un poco el asunto. En la figura aparece un objeto, como un rombo alargado, visto desde un punto a una distancia l, siendo d la diagonal mayor del rombo. Lo importante desde nuestro punto de observación es el ángulo alfa que ocupa el objeto. Cuando hablemos del tamaño aparente del rombo, nos referiremos a dicho ángulo. Con un poco de trigonometría, vemos que

Una de las cosas más extrañas de la matemática es que muchas veces es difícil saber qué estudia una cualquiera de sus ramas. Un buen ejemplo de esto lo tenemos con la geometría . La inequívoca etimología de la palabra nos evoca mediciones de terrenos. Por lo tanto, la geometría sería la parte de la matemática que estudia las figuras, las porciones del plano y sus propiedades.

Una de las cosas más extrañas de la matemática es que muchas veces es difícil saber qué estudia una cualquiera de sus ramas. Un buen ejemplo de esto lo tenemos con la geometría . La inequívoca etimología de la palabra nos evoca mediciones de terrenos. Por lo tanto, la geometría sería la parte de la matemática que estudia las figuras, las porciones del plano y sus propiedades. La teoría de números es sin duda alguna uno de los apartados más enigmáticos y que mayor fascinación han despertado desde siempre. Se trata de algo tan fácil de definir como el estudio de un único conjunto: el discreto (nunca mejor dicho) conjunto N . Sabemos positivamente que jamás el ser humano será capaz de responder todas las preguntas que dicho humilde conjunto nos plantea; y lo sabemos porque es muy fácil comprender que el número de preguntas diferentes que tiene capacidad de plantearnos es sencillamente infinito.

La teoría de números es sin duda alguna uno de los apartados más enigmáticos y que mayor fascinación han despertado desde siempre. Se trata de algo tan fácil de definir como el estudio de un único conjunto: el discreto (nunca mejor dicho) conjunto N . Sabemos positivamente que jamás el ser humano será capaz de responder todas las preguntas que dicho humilde conjunto nos plantea; y lo sabemos porque es muy fácil comprender que el número de preguntas diferentes que tiene capacidad de plantearnos es sencillamente infinito. se invierte para un número muy grande.

se invierte para un número muy grande.

Ya lo hemos dicho alguna vez: la matemática no es el arte de hacer conjeturas. Es el arte de hacer demostraciones. Y de hacerlas bien. Cantidad de conjeturas se han demostrado falsas a lo largo de los siglos, es tan fácil hacer una conjetura...

Ya lo hemos dicho alguna vez: la matemática no es el arte de hacer conjeturas. Es el arte de hacer demostraciones. Y de hacerlas bien. Cantidad de conjeturas se han demostrado falsas a lo largo de los siglos, es tan fácil hacer una conjetura...

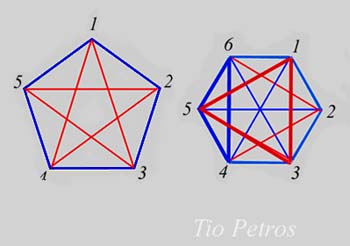

Los últimos post del mes de Febrero trataban de explicar el enunciado (que no la demostración) del Teorema de Ramsey . Comentamos entonces que dedicaríamos varios comentarios a aplicaciones prácticas del mismo, para acabar de comprender el sentido profundo del teorema.

Los últimos post del mes de Febrero trataban de explicar el enunciado (que no la demostración) del Teorema de Ramsey . Comentamos entonces que dedicaríamos varios comentarios a aplicaciones prácticas del mismo, para acabar de comprender el sentido profundo del teorema.

Acabo de ver por la red

Acabo de ver por la red  Continuamos con lo prometido. Tenemos definido el conjunto vacío, lo cual pueda parecernos poca cosa, pero eso es todo con lo que tenemos que trabajar si no queremos introducir axiomas adicionales.

Continuamos con lo prometido. Tenemos definido el conjunto vacío, lo cual pueda parecernos poca cosa, pero eso es todo con lo que tenemos que trabajar si no queremos introducir axiomas adicionales.

No parece que exista disciplina científica cuyo objeto sea tan difícil de precisar como la matemática. Precisamente por ello es doblemente importante establecer un buen punto de partida: unas bases desde las que edificar el edificio entero.

No parece que exista disciplina científica cuyo objeto sea tan difícil de precisar como la matemática. Precisamente por ello es doblemente importante establecer un buen punto de partida: unas bases desde las que edificar el edificio entero.

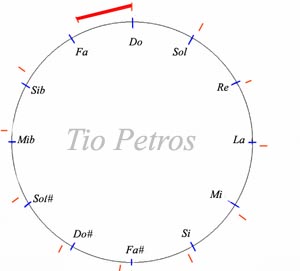

Según veíamos en el post anterior, las escalas musicales occidentales antiguas se construyeron en torno a la idea de producir la máxima consonancia posible; cosa que ocurría cuando la relación de las frecuencias de dos tonos tocados simultáneamente era expresable mediante una fracción lo más simple posible. Dado que un tono base y otro de frecuencia doble dan la sensación del mismo tono pero más agudo, lo natural era considerar esa distancia como la total que había que subdividir; independientemente de que pudiera adjuntarse otra hasta la frecuencia triple, cuádruple, etc...

Según veíamos en el post anterior, las escalas musicales occidentales antiguas se construyeron en torno a la idea de producir la máxima consonancia posible; cosa que ocurría cuando la relación de las frecuencias de dos tonos tocados simultáneamente era expresable mediante una fracción lo más simple posible. Dado que un tono base y otro de frecuencia doble dan la sensación del mismo tono pero más agudo, lo natural era considerar esa distancia como la total que había que subdividir; independientemente de que pudiera adjuntarse otra hasta la frecuencia triple, cuádruple, etc...