Prolegómenos a la integral de Lebesgue

Vistos los problemas que tenemos con ciertas funciones, relativamente sencillas de definir y de muy mal comportamiento, la estrategia de Lebesgue es bien diferente de la estrategia de Riemann.

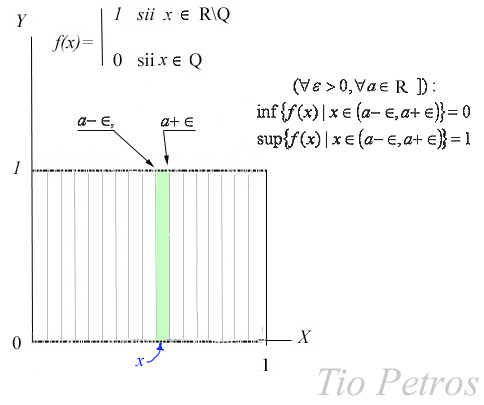

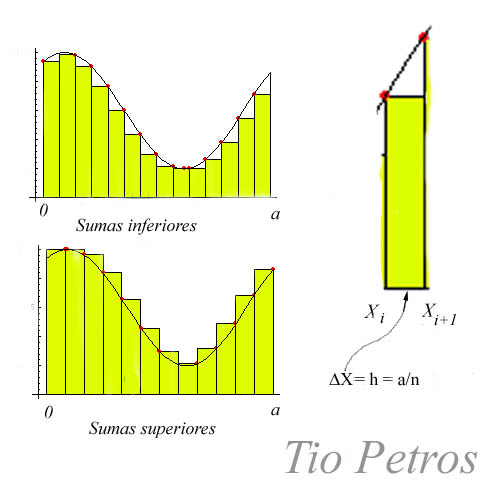

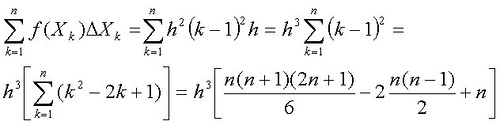

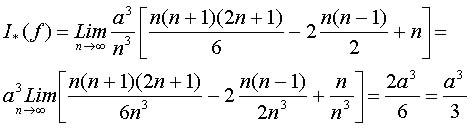

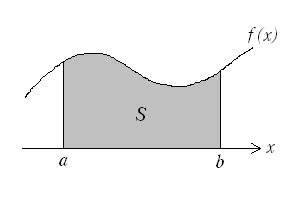

Cuando integramos en el sentido de Riemann, definimos una operación de conteo en gran medida de forma independiente de los valores que adopta la función, y así pasa lo que hemos visto con funciones como la de Dirichlet. Las sumas que aproximan la integral de Riemann provienen de partir el intervalo de integración en particiones sucesivamente más finas, y aproximar el área bajo la gráfica por exceso y por defecto mediante rectángulos, como hemos visto hace dos posts. Si tenemos una función de buen comportamiento , la diferencia entre las medidas por exceso y por defecto tenderán a cero cuando aumentamos la finura de la partición, en cuyo caso la función es Riemann-integrable.

Es importante comprender que en este método las particiones se realizan de forma independiente de los valores de la función.

Lebesgue, intentando extrapolar el concepto de integral a todas la funciones construibles, partió de un punto totalmente diferente. Fijándose precisamente en qué trozos del intervalo de integración la función tomaba ciertos valores.

Dado que en la generalidad más absoluta tendremos funciones que varíen continuamente, se trataba de aproximar cualquier función mediante lo que se llamaron funciones simples. Así pues, al definir la integral de Lebesgue la propia función es la que determinará los conjuntos sobre los que se definen las funciones simples que sirven para definir la función que queremos integrar. Es un proceso constructivo que se puede aplicar a toda función constructiva, y que requiere una cierta tranquilidad para ser visto convenientemente, por lo que lo haremos sin prisas, deteniéndonos donde sea necesario.

El proceso que seguiremos será más o menos el siguiente:

1.- Definiremos qué es una función medible en un espacio de medida.

2.- Definiremos qué es una función simple, y veremos que es un tipo de funciones medibles.

3.- Definiremos la integra de Lebesgue de funciones simples.

4.- Veremos cómo cualquier función medible se puede expresar como llímite de una función simple, y definiremos la integral de Lebesgue de funciones simples.

Será entonces cuando, en virtud de las buenas propiedades en el límite de esta integral, podremos extrapolar el concepto de integral de Lebesgue a toda función medible, construible mediante el paso al límite de funciones simples.

Nos llevaremos la sorpresa de que una función diabólica como la de Dirichlet cae en el paso tres, sin siquiera necesidad de pasos al límite.

De momento, ese es el guión; pero vaya por delante un comentario coloquial sobre la diferencia de las integraciones en el sentido de Riemann y de Legesgue que encontré en un libro sobre el tema:

Sobre una mesa hay esparcidas una serie de monedas. Para contar la cantidad de dinero que hay sobre la mesa Riemann dividiría la misma en una serie de bandas, calculando el dinero que cae dentro de cada banda para sumar después. Lebesgue sin embargo agruparía las monedas de valores iguales en montones, calcularía fácilmente el valor de cada montón y luego sumaría los montones.

Volveremos a este símil una vez explicado todo el asunto.

En la imagen que encabeza el post, tienen a Henry León Lebesgue (1875-1941) , matemático francés que dió su nombre (entre otras cosas) a esta nueva manera de entender la integración.