Entropía y cantidad de información (y 4)

Vamos a intentar sacarle jugo a la fórmula de la entropía de una variable aleatoria. En todo caso hablaremos de variables aleatorias discretas, que pueden tomar un número finito o al menos numerable de valores, sin embargo la extrapolación a variables continuas es muy sencilla y no añade dificultad conceptual alguna.

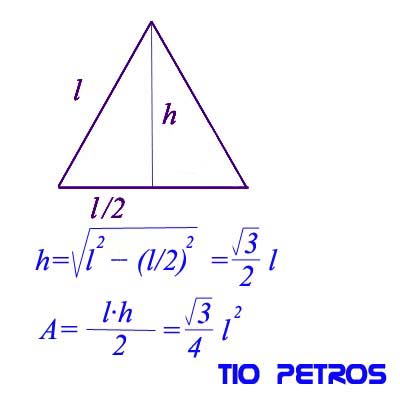

Primero, volvemos a poner la ilustración del post anterior, en la que se ve además el origen del concepto de entropía a partir de la cantidad de información aportada por cada posible valor de la variable aleatoria.

Puede suceder que uno de los posibles valores xi tenga asociada una probabilidad pi=1. Como la suma de todas las probabilidades es la unidad, eso quiere decir que los demás "posibles sucesos" tienen probabilidad cero (no son posibles, de ahí el entrecomillado anterior).

Una variable así nos está diciendo que se va a realizar el valor xi con seguridad. A una variable aleatoria de este tipo la denominaremos degenerada , por no aportar aleatoriedad alguna.

Qué sucede con la entropía de una variable aleatoria degenerada?

Sólo tiene un valor con probabilidad mayor que cero, por lo que dicha probabilidad es uno; y para ese valor el logaritmo de la probabilidad es cero (pues log21=0), por lo que la entropía de dicha variable es nula.

Una v. a. nos está ofreciendo una cierta información; es como cuando el médico nos dice que tenemos un 88% de posibilidades de vencer nuestra enfermedad. No nos da tanta información como cuando nos dice con seguridad qué nos va a pasar; pero nos da más información que si nos habla de un 50% de posibilidades. La variable aleatoria degenerada no deja aleatoriedad: da la información máxima posible, y tiene entropía nula, según acabamos de ver.

Este hecho es el primer indicio de que si pensábamos que la entropía era una medida de la información que me ofrece una variable aleatoria, estábamos equivocados.

LA ENTROPIA DE UNA VARIABLE ALEATORIA NO NOS INDICA EL GRADO DE INFORMACION QUE NOS OFRECE DICHA VARIABLE

De hecho, es un muy buen indicador de lo contrario. Cuanto más baja sea la entropía de una v. a., más información nos estará dando, hasta llegar a la entropía nula en el caso de información puntual, fiel y no probabilística (en el sentido de que la ofrece con probabilidad 1)

El hecho de que hayamos dicho que la entropía era el valor esperado de la cantidad de información asociada a los valores posibles no nos debe llevar a engaño: una cosa es la información que aporta la variable aleatoria en sí, y otra es el incremento de información que nos supone el conocimiento de la materialización práctica del valor de dicha variable en un experimento. Bajo esta luz es evidente que un suceso de probabilidad uno tenga información asociada nula: ¿qué información nos va a aportar, si la variable aleatoria ya nos da toda la información posible?

Si el médico me dice que tengo una probabilidad del 100% de curarme de mi enfermedad (variable aleatoria degenerada) me aporta de principio la máxima información. Cuando me he curado (realización práctica del suceso predicho por la variable), ya no obtengo información añadida. En el extremo opuesto, si me dice que tengo un 50% de probabilidades de curación (máxima aleatoriedad) no me aporta información alguna, y mi futura curación (realización del experimento asociado a la variable aleatoria) en cambio aportará toda la información que la variable no aportaba.

La entropía de la variable es la medida esperada de la información que aportará la realización del evento asociado a la variable, no la propia variable. Por eso es que una entropía alta implica que la propia variable aporta una información pequeña. El resto de la información hasta la certeza vendrá de la materialización práctica del evento.

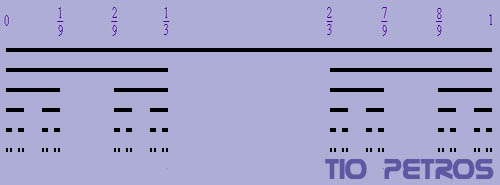

Vayamos a uno de los casos más sencillos de variable aleatoria: la realización de un experimento con dos posibles resultados, de probabilidad p y (1-p). El lanzamiento de una moneda (con posibles resultados 0 (cara) y 1 (cruz), o de un dado con resultados 0 (impar) ó 1 (par).

La entropía de esta variable , aplicando la fórmula de la definición es:

H[X]= -p·log2p-(1-p)·log2(1-p)

En el caso general tenemos infinitas distribuciones diferentes con este esquema dependiendo del valor de p, que recorre los reales en el intervalo [0,1].

Un poco de cálculo nos convencerá de que el valor máximo de la entropía es para p=0,5, y los mínimos para p=0 y p=1, para los cuales la entropía vale cero. En efecto, en ambos casos tenemos una variable degenerada; y la máxima entropía se da cuando la distribución es uniforme: todos los valores tienen la misma probabilidad de ocurrir y la variable en sí no nos aporta información alguna de cuál puede ser el que se dé en el evento.

Ahora sabemos que el máximo de entropía es para la distribución uniforme, además es muy sencillo evaluarla:

Si tenemos una v. a. X que toma valores {x1,x2,...,xn} con probabilidades (p1,p2,...,pn), si hay equiprobabilidad entonces pi=1/n, para todo n, y por lo tanto:

H[X]=-(1/p)·log2(1/p)-(1/p)·log2(1/p)-...-(1/p)·log2(1/p)=

log2(p)

Esta es la mayor entropía que puede tener una variable aleatoria de n estados.

Esta fórmula:

H[X]=log2(p)

es idéntica a la fórmula física que expresa la entropía de un sistema en función de su número de estados, salvo por la presencia de la constante de Boltzmann. Tanto en el caso físico como aquí, la elección del valor numérico de la constante depende de las unidades en las que estemos trabajando. En nuestro caso hemos elegido el asunto al dar base 2 a los logaritmos empleados y la unidad es el bit.

Así, una variable con 8 estados, si es uniformemente distribuida y por lo tanto aporta la menor información posible; tiene una entropía de H=log28=3 bits.

Habiendo ocho estados son precisamente 3 los bits necesarios para nombrarlos a todos (000,001,010,011,100,101,110 y 111). Esto no tiene nada de casual, sino todo lo contrario; pero es una historia que debe ser contada en otra ocasión... ocasión que deberá esperar pues este blog suspende su actividad hasta mediados-finales de Julio por motivos vacacionales.

Volveremos entonces con más energía. Que pasen un buen verano (o invierno, si nos leen desde el hemisferio sur).

,

,  ,

,  ,

,  , se verifica lo siguiente (reglas básicas de aritmética modular):

, se verifica lo siguiente (reglas básicas de aritmética modular): y

y  , entonces

, entonces

y

y  , entonces

, entonces

tal que

tal que  , y si

, y si  tal que

tal que  .

.

al

al y la relación binaria de equivalencia de congruencia módulo m (para m un entero positivo), se cumple:

y la relación binaria de equivalencia de congruencia módulo m (para m un entero positivo), se cumple: ,

,  , se definen las operaciones suma y multiplicación en

, se definen las operaciones suma y multiplicación en

, tiene elemento opuesto para la operación de suma definida, siendo este opuesto el elemento

, tiene elemento opuesto para la operación de suma definida, siendo este opuesto el elemento  . Además, si m es primo, para todo

. Además, si m es primo, para todo  , se cumple que [a] tiene inverso multiplicativo, y además este inverso es único.

, se cumple que [a] tiene inverso multiplicativo, y además este inverso es único. , y lo denotaremos por

, y lo denotaremos por  si existe un

si existe un  tal que

tal que  .

. y, en segundo lugar, existe

y, en segundo lugar, existe  tal que

tal que  . Así, escribiremos que

. Así, escribiremos que  .

. y, segundo, existe

y, segundo, existe  tal que

tal que  . Por tanto, podemos escribir que

. Por tanto, podemos escribir que  .

.

, y la expansión de arriba es la que le corresponde al estar trabajando en base 10.

, y la expansión de arriba es la que le corresponde al estar trabajando en base 10. , para i entre 0 y n.

, para i entre 0 y n.

. Por

. Por , luego

, luego  . No es difícil comprobar que, en general,

. No es difícil comprobar que, en general,  para

para

. O lo que es lo mismo, que x0 sea un múltiplo de 2. Es decir, que la cifra de las unidades sea par.

. O lo que es lo mismo, que x0 sea un múltiplo de 2. Es decir, que la cifra de las unidades sea par.

, luego

, luego  . No es difícil comprobar que, en general,

. No es difícil comprobar que, en general,  para cualquier k mayor o igual que 1.

para cualquier k mayor o igual que 1.

.

.

, luego

, luego  . No es difícil comprobar que, en general,

. No es difícil comprobar que, en general,  para cualquier k mayor o igual que 1.

para cualquier k mayor o igual que 1.

. O lo que es lo mismo, que x0 sea un múltiplo de 5. Es decir, que la cifra de las unidades sea cero o cinco.

. O lo que es lo mismo, que x0 sea un múltiplo de 5. Es decir, que la cifra de las unidades sea cero o cinco.

, luego

, luego  . No es difícil comprobar que, en general,

. No es difícil comprobar que, en general,  para cualquier k mayor o igual que 1.

para cualquier k mayor o igual que 1.

. Es decir, que la suma de sus cifras sea divisible entre 9.

. Es decir, que la suma de sus cifras sea divisible entre 9.

, luego

, luego  . No es difícil comprobar que, en general,

. No es difícil comprobar que, en general,  para cualquier k mayor o igual que 1.

para cualquier k mayor o igual que 1.

. O lo que es lo mismo, que x0 sea un múltiplo de 10. Es decir, que la cifra de las unidades sea cero.

. O lo que es lo mismo, que x0 sea un múltiplo de 10. Es decir, que la cifra de las unidades sea cero.

. Por la segunda regla de operaciones con congruencias,

. Por la segunda regla de operaciones con congruencias,  , luego

, luego  . No es difícil comprobar que, en general:

. No es difícil comprobar que, en general:

, lo que es equivalente a que, como dice el enunciado de la regla, la suma de las cifras en las posiciones pares menos la suma de las cifras en las posiciones impartes sea divisible entre 11.

, lo que es equivalente a que, como dice el enunciado de la regla, la suma de las cifras en las posiciones pares menos la suma de las cifras en las posiciones impartes sea divisible entre 11.

, al dividir abcabc entre 1001, el resultado es, precisamente, abc.

, al dividir abcabc entre 1001, el resultado es, precisamente, abc.

,

,  ,

,  y

y  . Aplicando esta regla, calculemos:

. Aplicando esta regla, calculemos:  , y 0 es divisible entre 13. Luego 4394 es divisible entre 13.

, y 0 es divisible entre 13. Luego 4394 es divisible entre 13.

) y producto (

) y producto (  ). Vamos a definir una relación binaria de equivalencia en

). Vamos a definir una relación binaria de equivalencia en  y a continuación ver qué tiene que ver con lo que pretendemos llevar adelante: las reglas de divisibilidad.

y a continuación ver qué tiene que ver con lo que pretendemos llevar adelante: las reglas de divisibilidad. un entero positivo. Decimos que dos números enteros

un entero positivo. Decimos que dos números enteros  ,

,  son congruentes módulo

son congruentes módulo  tal que

tal que  . Para denotar esta situación, se utiliza la notación:

. Para denotar esta situación, se utiliza la notación:  . Vamos a comprobar que la relación de congruencia módulo m es una relación binaria de equivalencia. Es muy sencillo, y lo hacemos a modo de ilustrar un poco más el procedimiento.

. Vamos a comprobar que la relación de congruencia módulo m es una relación binaria de equivalencia. Es muy sencillo, y lo hacemos a modo de ilustrar un poco más el procedimiento. , ¿se cumplirá que

, ¿se cumplirá que  ? Es decir, ¿tendremos que existirá un

? Es decir, ¿tendremos que existirá un  ? Como

? Como  , es evidente que si escogemos

, es evidente que si escogemos  , se cumple entonces que

, se cumple entonces que  , supongamos que

, supongamos que  . ¿Se cumplirá que

. ¿Se cumplirá que  ? Esto será así si existe un

? Esto será así si existe un  . Ahora bien, sabemos por hipótesis que

. Ahora bien, sabemos por hipótesis que  luego, por definición de la relación, se verifica que existe un

luego, por definición de la relación, se verifica que existe un  , tenemos entonces que

, tenemos entonces que  . Tomamos pues el entero

. Tomamos pues el entero  (si

(si  tales que

tales que  , ¿será cierto que

, ¿será cierto que  ? Esto será así si existe un

? Esto será así si existe un  .

. . Igualmente, como

. Igualmente, como  .

. :

:

, es claro pues que se verifica la propiedad transitiva, y ya tenemos probada la condición de equivalencia de la relación binaria definida.

, es claro pues que se verifica la propiedad transitiva, y ya tenemos probada la condición de equivalencia de la relación binaria definida. ,

,  ,

,  , ...,

, ...,  . La clase de equivalencia del cero serán todos aquellos números múltiplos de m. La clase de equivalencia del uno serán todos aquellos números tales que al dividir por m, nos dan de resto 1. La clase de equivalencia del dos serán todos aquellos números tales que al dividir por m, nos dan de resto 2. Y así hasta el

. La clase de equivalencia del cero serán todos aquellos números múltiplos de m. La clase de equivalencia del uno serán todos aquellos números tales que al dividir por m, nos dan de resto 1. La clase de equivalencia del dos serán todos aquellos números tales que al dividir por m, nos dan de resto 2. Y así hasta el  .

.

coincide con la clase de equivalencia del 1. Y así, sucesivamente.

coincide con la clase de equivalencia del 1. Y así, sucesivamente. , existen dos números enteros c y r tales que

, existen dos números enteros c y r tales que  , con

, con  . Los enteros c y r (cociente y resto, respectivamente) son únicos, dados a y b.

. Los enteros c y r (cociente y resto, respectivamente) son únicos, dados a y b.

a cualquier subconjunto de A x A, y diremos que los pares (a, b) de dicho subconjunto están relacionados por

a cualquier subconjunto de A x A, y diremos que los pares (a, b) de dicho subconjunto están relacionados por  al conjunto de los números naturales,

al conjunto de los números naturales,  , considerando su producto cartesiano,

, considerando su producto cartesiano,  , podemos establecer la relación tal que relaciona a cualquier n1 con su doble, 2n1. Es claro que el conjunto

, podemos establecer la relación tal que relaciona a cualquier n1 con su doble, 2n1. Es claro que el conjunto  es un subconjunto de

es un subconjunto de  y por tanto la relación establecida es una relación binaria.

y por tanto la relación establecida es una relación binaria. . ¿Es de equivalencia esta relación binaria? Para contestar afirmativamente tendremos que demostrar que se cumplen las tres propiedades. Para contestar negativamente, bastará con encontrar que falla una de ellas.

. ¿Es de equivalencia esta relación binaria? Para contestar afirmativamente tendremos que demostrar que se cumplen las tres propiedades. Para contestar negativamente, bastará con encontrar que falla una de ellas. .

. .

. .

. . Pero:

. Pero:

.

. . Pero esto sólo es así si

. Pero esto sólo es así si  .

. , entonces

, entonces  .

. , definimos su clase de equivalencia

, definimos su clase de equivalencia

como el conjunto de todas estas clases de equivalencia. Lo expresaremos formalmente como sigue:

como el conjunto de todas estas clases de equivalencia. Lo expresaremos formalmente como sigue:

,

,  , y que

, y que  .

.